[Linux]부트캠프 - 파일 및 폴더 생성

파일 및 폴더 생성

개발한 분의 딸의 애착인형 이름이 하둡

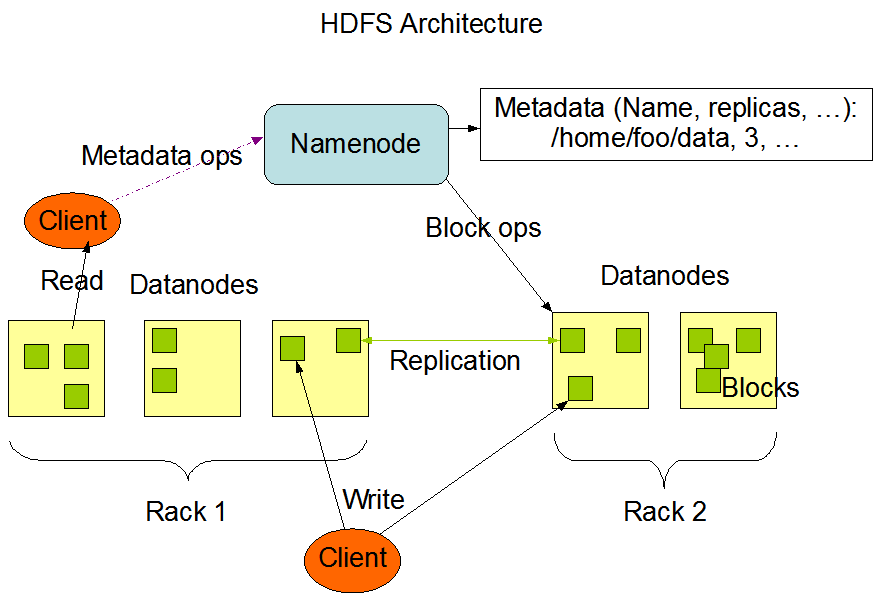

Hadoop Distributed File System

구글파일시스템을 기반으로 만든 대용량 분산 저장 / 처리 파일 시스템

NameNode와 DataNode를 가지는 Master - Slave 구조

하둡의 가정 및 목표

❗우분투 리눅스가 깔려있어야합니다.❗

우선 우분투 가상컴퓨터에서

sudo apt install openssh-server ssh-askpass -yssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

java 개발자용 다운해야함

OpenJDK(java development kit) vs Amazon Corretto

Amazon Corretto를 다운받을 것이다.

11version 다운 클릭

해당 내용을 우분투에 복사 후 입력

amazon-corretto가 우분투 안에 압축파일로 있을 것이다.

압축 풀기

tar xvzf amazon-corretto-11-x64-linux-jdk.tar.gz 입력java라는 바로가기 만들어주기

ln -s amazon-corretto-11.0.14.10.1-linux-64/ java 입력ls -al 로 숨겨진 파일을 확인하고, 숨겨져있던 .bashrc 파일의 내용을 vim 에디터로 수정하자.

.bahsrc는 터미널이 실행될 때 가장 먼저 읽혀지는 파일sudo vim ~/.bashrc

export JAVA_HOME=/home/계정명/java 입력export PATH=$PATH:$JAVA_HOME/bin 입력:wq! 입력vim 에디터에서 나와서 source ~/.bashrc 입력

source는 변경사항을 지금 당장 적용시켜달라는 명령java버전과 javac버전 확인

java -versionjavac -version

파이썬도 설치해야한다.(3.7이하 버전)

파이썬 3.8버전이 기존에 존재하지만 제플린과 호환이 안되기 때문에 따로 설치해줘야한다.

sudo add-apt-repository ppa:deadsnakes/ppa 입력

sudo apt update 입력

sudo apt install python3.7 -y

sudo vim ~/.bashrc

alias python=python3.7 입력alias python3=python3.7 입력:wq!로 저장하고 vim 에디터 종료source ~/.bashrc 로 변경사항 적용

python --version, python3 --version으로 버전 확인

sudo apt install python3-pip -y

.bashrc 파일 켜서 내용 추가

sudo vim ~/.bashrcalias pip="python3.7 -m pip" 내용 추가

:wq!로 vim 종료source ~/.bashrc 로 변경사항 적용

pip --version으로 버전 확인

이제 하둡을 다운 받을 차례다.

3.31버전 다운받을 것이다. 따라서 백업사이트로 가야한다.

tar.gz파일을 찾아서 링크주소를 복사해온다.

우분투에서 wget https://downloads.apache.org/hadoop/common/hadoop-3.3.1/hadoop-3.3.1.tar.gz 입력 해서 압축파일 다운

압축 풀기

tar xvzf hadoop-3.3.1.tar.gzhadoop 이라는 바로가기 만들어주기

ln -s hadoop-3.3.1 hadoop배쉬가 실행될 때 하둡이 켜지게 환경변수 설정(PATH 등 설정)

sudo vim ~/.bashrc 실행 후 작성

이번엔 동일파일에서 하둡을 사용할 수 있는 유저 설정

big자리에 자신이 원하는 계정명을 적어주면 된다.:wq!: 로 저장 후 에디터를 종료변경사항 바로 적용

source ~/.bashrc경로 바꾸기

cd $HADOOP_CONF_DIRls

건드려야하는 파일 몇 가지가 있다.

hadoop-env.sh

vim hadoop-env.sh

core-site.xml

vim core-site.xml

hdfs-site.xml

vim hdfs-site.xml

mapred-site.xml

vim mapred-site.xml

설정이 끝났으면 네임/데이터 노드 포매팅 해주기

hdfs namenode -formathdfs datanode -format프레임워크 실행

start-dfs.shstart-yarn.shjps

stop-all.sh

stop-dfs.shstop-yarn.shsudo apt purge openssh-serversudo apt install openssh-serverhdfs dfsadmin -report : 하둡에 관련 정보

파이어폭스를 켜서 localhost:9870으로 가보자.

이번엔 localhost:8088로 가보자

아파치 스파크 홈페이지의 다운로드로 가서 버전을 3.1.3 버전을 선택하고, pre-built with user-provided Apache hadoop 을 선택 후 3번의 다운로드 링크 클릭

링크 주소 복사.

우분투에서 wget을 사용해서 다운

wget https://dlcdn.apache.org/spark/spark-3.1.3/spark-3.1.3-bin-without-hadoop.tgz압축해제 후 spark라는 심볼릭 링크 만들기

tar xvzf spark-3.1.3-bin-without-hadoop-tgzln -s spark-3.1.3-bin-without-hadoop spark

경로 잡기

sudo vim ~/.bashrc

바로 적용시키기

source ~/.bashrccd $SPARK_HOME/conf 로 경로 이동

파일 복사

cp workers.template workers

cp spark-env.sh.template spark-env.sh

vim spark-env.sh

cp spark-defaults.conf.template spark-defaults.conf

vim spark-defaults.conf

spark.master yarncd 엔터하고

start-dfs.shstart-yarn.shpyspark이런 화면이 나온다면 성공⭕

파일 및 폴더 생성

파일 시스템 탐색

도움말(man -> manual)

명령어 기초

유닉스(Unix)

특정 코드 지연 실행 - DispatchQueue.main.asyncAfter(deadline: )

Naming Conventions

안드로이드 폰과 맥북에어 M1 USB 테더링 성공

Simulator 풀 스크린 사용 방법

10807번 - 개수 세기

프로그래머스 Lv.1 풀이 코드 모음

프로그래머스 Lv.1 풀이 코드 모음

11047번 - 동전 0

11659번 - 구간 합 구하기 4

14888번 - 연산자 끼워넣기

9184번 - 신나는 함수 실행

24416번 - 알고리즘 수업 - 피보나치 수 1

2580번 - 스도쿠

9663번 - N-Queen

15652번 - N과 M (4)

15651번 - N과 M (3)

15650번 - N과 M (2)

25305번 - 커트라인

25304번 - 영수증

3003번 - 킹, 퀸, 룩, 비숍, 나이트, 폰

15649번 - N과 M (1)

2004번 - 조합 0의 개수

1676번 - 팩토리얼 0의 개수

9375번 - 패션왕 신해빈

1010번 - 다리 놓기

11051번 - 이항 계수 2

11050번 - 이항 계수 1

3036번 - 링

2981번 - 검문

1934번 - 최소공배수

2609번 - 최대공약수와 최소공배수

1037번 - 약수

5086번 - 배수와 약수

1358번 - 하키

1004번 - 어린 왕자

1002번 - 터렛

3053번 - 택시 기하학

2477번 - 참외밭

4153번 - 직각삼각형

3009번 - 네 번째 점

1085번 - 직사각형에서 탈출

11478번 - 서로 다른 부분 문자열의 개수

1269번 - 대칭 차집합

1764번 - 듣보잡

10816번 - 숫자 카드 2

1620번 - 나는야 포켓몬 마스터 이다솜

14425번 - 문자열 집합

10815번 - 숫자 카드

18870번 - 좌표 압축

10814번 - 나이순 정렬

1181번 - 단어 정렬

11651번 - 좌표 정렬하기 2

11650번 - 좌표 정렬하기

1427번 - 소트인사이드

2108번 - 통계학

10989번 - 수 정렬하기 3

2751번 - 수 정렬하기 2

2750번 - 수 정렬하기

22.06.25 ~ 27 부산 먹부림 기록

1436번 - 영화감독 숌

1018번 - 체스판 다시 칠하기

7568번 - 덩치

2231번 - 분해합

2798번 - 블랙잭

11729번 - 하노이 탑 이동 순서

2447번 - 별 찍기 - 10

17478번 - 재귀함수가 뭔가요?

10870번 - 피보나치 수 5

10872번 - 팩토리얼

9020번 - 골드바흐의 추측

4948번 - 베르트랑 공준

1929번 - 소수 구하기

11653번 - 소인수분해

2581번 - 소수

1978번 - 소수 찾기

10757번 - 큰 수 A+B

2839번 - 설탕 배달

2775번 - 부녀회장이 될테야

10250번 - ACM 호텔

2869번 - 달팽이는 올라가고 싶다

1193번 - 분수찾기

2292번 - 벌집

1712번 - 손익분기점

1316번 - 그룹 단어 체커

2941번 - 크로아티아 알파벳

5622번 - 다이얼

2908번 - 상수

1152번 - 단어의 개수

1157번 - 단어 공부

2675번 - 문자열 반복

10809번 - 알파벳 찾기

11720번 - 숫자의 합

11654번 - 아스키 코드

1065번 - 한수

4673번 - 셀프 넘버

15596번 - 정수 N개의 합

4344번 - 평균은 넘겠지

8958번 - OX퀴즈

25083번 - 새싹

Spark Bigdata Pipeline

Spark 3일차

Spark 2일차

1546번 - 평균

Spark 1일차

Hadoop🐘

3052번 - 나머지

2577번 - 숫자의 개수

2562번 - 최댓값

10818번 - 최소, 최대

Linux

MongoDB 조회 문제

MongoDB

1110번 - 더하기 사이클

10951번 - A+B - 4

Oracle 3️⃣

ORACLE 연습용 문제 만들기 숙제

10952번 - A+B - 5

Oracle 2️⃣

2480번 - 주사위 세개

Oracle Day1️⃣

Tensorflow

Big Data

2525번 - 오븐 시계

10871번 - X보다 작은 수

2439번 - 별 찍기 - 2

2438번 - 별 찍기 - 1

11022번 - A+B - 8

11021번 - A+B - 7

2742번 - 기찍 N

2741번 - N 찍기

15552번 - 빠른 A+B

8393번 - 합

10950번 - A+B - 3

9️⃣ 2739번 - 구구단

2884번 - 알람 시계

14681번 - 사분면 고르기

⛏크롤링(Crawling)

2753번 - 윤년

Django 복습 4️⃣

Django 복습 3️⃣

💯 9498번 - 시험 성적

1330번 - 두 수 비교하기

✖ 2588번 - 곱셈

➗ 10430번 - 나머지

Django 복습 2️⃣

Django 복습 1

MySQL 복습!

⁉10926번 - ??!

🆎1008번 - A/B

👩🦲 18108번 - 1998년생인 내가 태국에서는 2541년생?!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

🎈✨경 축✨🎈

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

선형 자료구조(1일차에 이어서)

🆎10998번 - A×B

🆎1001번 - A-B

🆎1000번 - A+B

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

🐶10172번 - 개

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

🐱10171번 - 고양이

[해당 포스트는 유튜버 나동빈님의 영상을 참고했습니다.]

❤10718번 - We love kriii

🖐2557번 - Hello World

Today I Learned(TIL)📌 (2021.12.31)

Today I Learned(TIL)📌 (2021.12.30)

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[Noitce] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!

[noitce!!] 고쳐야하거나 틀린 것이 있으면 말씀해주세요!